NvidiaはAIアプリケーションを高速化するGPU「HGX H200」を発表しました。このGPUの普及は、近い将来さらに強力なAIモデルや、ChatGPTのような既存のAIモデルの応答時間の高速化につながると期待されています。

*Category:

推論速度が大幅向上、Nvidiaの新型GPU「HGX H200」

GPUは一般的にはゲームやクリエイティブ用のグラフィックスを支えるチップを指しますが、一方でAIアプリケーションにおいても重要なものです。GPUは、AIモデル構築のトレーニング部分と、AIモデルに入力を与えて結果を返す「推論」部分において不可欠なものとなっています。

「HGX H200」は昨年発表された、NvidiaのAI GPUチップ「H100」の後続製品です。Nvidiaは「HGX H200」について、「世界で最もパワフルなGPU」だとアピールしています。

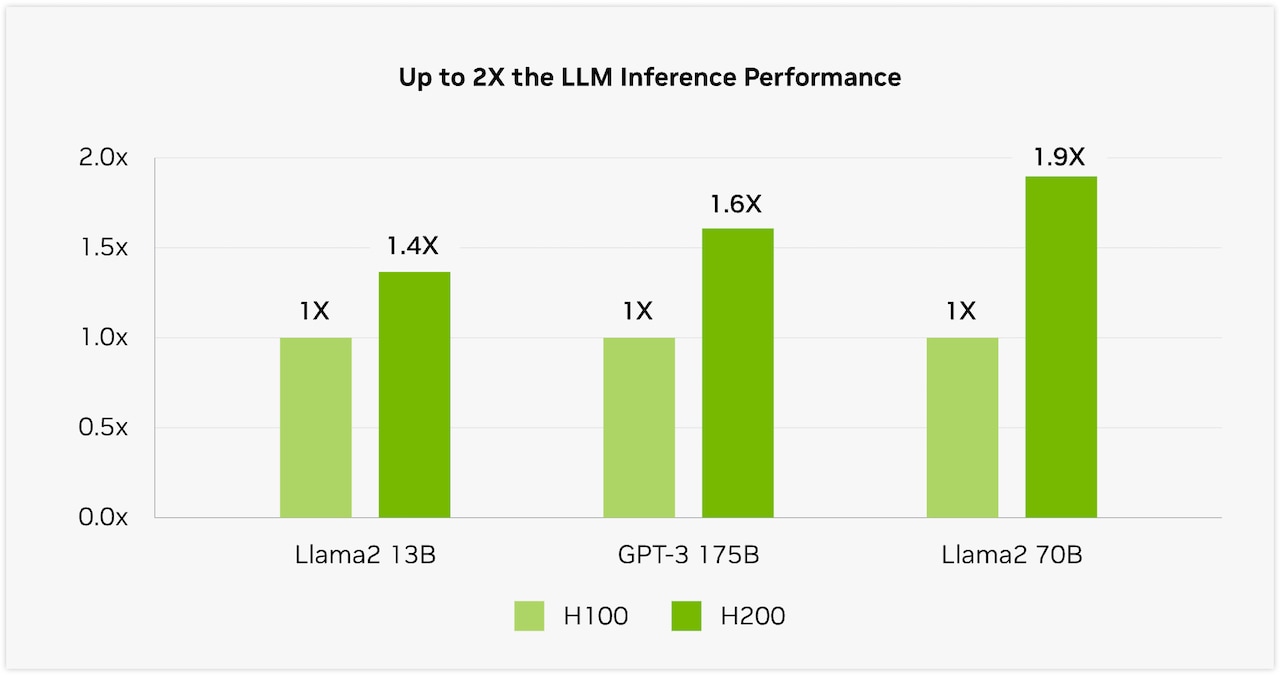

The introduction of H200 will lead to further performance leaps, including nearly doubling inference speed on Llama 2, a 70 billion-parameter LLM, compared to the H100. Additional performance leadership and improvements with H200 are expected with future software updates.

— 引用:Nvidia

訳:H200の導入により、700億パラメータのLLMであるLlama 2での推論速度がH100の約2倍になるなど、さらなる性能の飛躍が期待される。今後のソフトウェア・アップデートにより、H200のさらなる性能向上とリーダーシップが期待される。

Nvidiaが公開したグラフでは、OpenAIのLLM「GPT-3」の推論速度が、H100の1.6倍になっていることが確認できます。

またNvidiaによると、H200はHBM3eメモリを提供する最初のGPUとのこと。HBM3eのおかげで、H200は141GBのメモリと毎秒4.8テラバイトの帯域幅を提供し、2020年にリリースされたNvidia A100の2.4倍のメモリ帯域幅になったと主張しました。

テックメディア「Ars Technica」によると、コンピューティング・パワーの不足はこの1年、AIの進歩の大きなボトルネックとなっており、既存のAIモデルの展開を妨げ、新しいモデルの開発を遅らせているとのこと。AIモデルを加速させる強力なGPUの不足が主な原因とされています。

このボトルネックを緩和する1つの方法は、より多くのチップを製造することですが、現状では2020年に発売された「A100」が依然として高い需要があるほどGPUは不足しています。

例えばAI大手のOpenAIは、GPUリソースが不足しており、ChatGPTの速度低下を引き起こしていると繰り返し述べています。そのため同社は、サービスを提供するためにレート制限に頼らざるを得ません。

「Ars Technica」は、H200を使うことで、ChatGPTを実行する既存のAI言語モデルに余裕が生まれ、より多くの顧客にサービスを提供できるようになるかもしれないと指摘しています。

なお「H200」の価格は明かされていませんが、前モデルのH100の価格は約3万ドル(約455万円)と非常に高額でした。一方で、ChatGPTはトレーニングに10,000台以上のGPUを必要とし、継続的な運用にはさらに多くのリソースを必要とすると報告されています。H200の登場は、ビッグテック同士のAIへの投資競争をさらに刺激するものとなりそうです。