つい最近まで、フェイク画像を作る方法は、写真を切り貼りするか、フォトショップを使いこなして合成するしかありませんでした。しかし現在では、写真のようなリアルなディープフェイクが、誰でも出来る時代に入り始めています。

この画像生成AIによるディープフェイクの精度と危険性を、テック系メディア「Ars Technica」が実験を通して解説しています。

*Category:

画像生成AIが「たった数枚のSNS画像」からディープフェイクを生成

今回の「Ars Technica」の実験で、フェイク画像の対象となったのは「ジョン」というこちらの男性。

もちろん彼は実在する人物ではなく、AIが合成した架空の人物です。「Ars Technica」は当初ボランティアを募って、実在する人物で実験を行おうとしていたものの、風評被害リスクが高すぎることから取りやめたとのこと。

そこで、代わりにAIを使って作られたのが「ジョン」。彼は全くの架空の人物であるため、心配は無用です。今回のシナリオでは、ジョンは小学校の教師で、この12年間、仕事中や自宅、あるいは外出先で撮った写真をFacebookに投稿してきたという設定です。

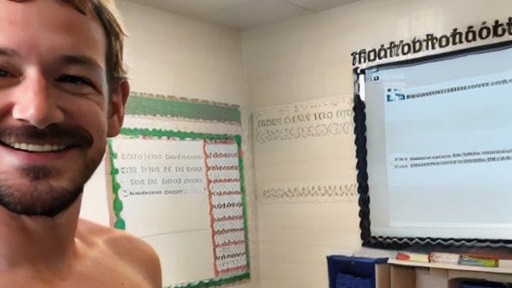

彼の投稿から入手したという設定の画像は以下の7枚。よく見ればAI生成画像だと分かりますが、どれも無難で実際にありそうな写真です。

この7枚の画像だけを使って、AIに訓練させれば、ジョンの悪事を証明するような「証拠写真」を生成することができます。

例えば、こちらは教室でジョンが上裸になっている画像。文字などがおかしくなっていますが、写っているジョンにはほとんど不自然さはありません。

こちらは浮気の証拠写真。よく見ると背景が不自然ですが、このような弁明しづらい状況のフェイク写真は厄介です。

他にも、ジョンが秘密の軍事組織に属していたかのような画像すら作成することができます。一度データセットを作成してしまえば画像を作り放題なので、それっぽい画像の生成は容易でしょう。

「Ars Technica」は、フリーの画像生成AI「Stable Diffusion」に「Dreambooth」という技術を使い、今回の画像を作成したとのこと。画像生成にかかった時間は約1時間で、これは多くの不完全な画像を選別し、最適な画像を見つけるために試行錯誤を重ねた結果だそうです。

「Dreambooth」は、Googleと米ボストン大学の共同研究によって最近発表された技術です。Dreamboothを使うことで、ファインチューニングと呼ばれるプロセスを経て、Stable DiffusionのAIモデルに新しいテーマを教えることができます。

Today, along with my collaborators at @GoogleAI, we announce DreamBooth! It allows a user to generate a subject of choice (pet, object, etc.) in myriad contexts and with text-guided semantic variations! The options are endless. (Thread 👇)

webpage: https://t.co/EDpIyalqiK

1/N pic.twitter.com/FhHFAMtLwS— Nataniel Ruiz (@natanielruizg) August 26, 2022

同メディアは、ジョンは存在しないものの、他の実在する人物にも適用可能だと指摘しました。生成された画像は完璧とはいい難いものですが、AIの精度は日進月歩で進化しています。また、画像を荒くすれば、AIの精度の低さをごまかすこともできてしまうかもしれません。

「Ars Technica」の記者であるベンジ・エドワーズ氏はこれについて「SNS投稿を見直すべきかもしれない」と指摘しています。

もしあなたが、過去10年間に自分の写真をSNSに投稿した数十億人の一人なら、その行動を見直す時期が来ているかもしれません。新しいAI画像生成技術では、誰でも自分の写真(またはビデオフレーム)を一握りだけ保存し、AIを訓練して、あなたが恥ずかしいことや違法行為をしている様子を写したリアルなフェイク写真を作成することができます。

今回の技術とは別ですが、実際にディープフェイクの技術は様々なところで悪用されています。先日には、ウクライナのゼレンスキー大統領が「武器を放棄するよう兵士に呼びかける」ディープフェイク動画が、ハッキングされたウクライナのWEBサイトに投稿されたという報告もありました。

A deepfake of Ukrainian President Volodymyr Zelensky calling on his soldiers to lay down their weapons was reportedly uploaded to a hacked Ukrainian news website today, per @Shayan86 pic.twitter.com/tXLrYECGY4

— Mikael Thalen (@MikaelThalen) March 16, 2022

必要以上に怖がる必要はありませんが「このようなディープフェイクが誰でも使える」というのは事実。写真や動画は明確な証拠として見られがちですが、フェイクの可能性も十分あるということを忘れないようにしましょう。